Fortschritte im Bereich des maschinellen Lernens, der künstlichen Intelligenz, der eingebetteten Bildverarbeitung und der Verarbeitungstechnologie haben Innovatoren dabei geholfen, autonome Maschinen zu bauen, die in der Lage sind, sich in einer Umgebung mit wenig menschlicher Aufsicht zurechtzufinden. Beispiele für solche Geräte sind AMRs (Autonome mobile Roboter), autonome Traktoren, automatisierte Gabelstapler usw.

Und um diese Geräte wirklich autonom zu machen, müssen sie die Fähigkeit besitzen, ohne manuelle Navigation fortbewegen zu können. Dies wiederum erfordert die Fähigkeit, die Tiefe zu messen, um sie kartieren, lokalisieren, den Weg planen und Hindernisse erkennen und vermeiden zu können. Hier kommen Tiefenkameras ins Spiel. Tiefenkameras ermöglichen Maschinen eine 3D-Perspektive ihrer Umgebung.

In diesem Blog erfahren wir, was Tiefensensorkameras sind, welche verschiedenen Typen es gibt und wie sie funktionieren. Außerdem lernen wir die beliebtesten Embedded-Vision-Anwendungen kennen, die diese modernen Kameras verwenden.

Verschiedene Arten von Tiefensensorkameras und ihre Funktionen

Tiefenmessung ist die Messung der Entfernung von einem Gerät zu einem Objekt oder der Entfernung zwischen zwei Objekten. Zu diesem Zweck wird eine 3D-Tiefensensorkamera verwendet, die automatisch die Anwesenheit von Objekten in der Nähe erkennt und die Entfernung zu diesem Objekt während der Bewegung misst. Dies hilft dem mit der Tiefensensorkamera integrierten Gerät oder der Ausrüstung, sich autonom zu bewegen, indem intelligente Entscheidungen in Echtzeit getroffen werden.

Von allen heute verfügbaren Tiefentechnologien sind drei beliebtesten und am häufigsten verwendeten wie folgt:

- Stereo-Vision

- Time of flight

- Direkte Lichtlaufzeit (dToF)

- LiDAR

- Indirekte Lichtlaufzeit (iToF)

- Direkte Lichtlaufzeit (dToF)

- Strukturiertes Licht

Als Nächstes wollen wir uns das Funktionsprinzip jeder der oben aufgeführten Tiefensensortechnologien im Detail ansehen.

Stereo-vision

Eine Stereokamera basiert auf demselben Prinzip wie das menschliche Auge – binokulareVision. Die binokulare Vision des Menschen verwendet die sogenannte Stereodisparität, um die Tiefe eines Objekts zu messen. Stereodisparität ist die Technik zur Messung der Entfernung zu einem Objekt, indem der Unterschied in der Position eines Objekts ausgenutzt wird, wie sie von zwei verschiedenen Sensoren oder Kameras (wie die Augen beiMenschen) wahrgenommen wird.

Das folgende Bild veranschaulicht dieses Konzept:

Abbildung 1 – Stereo-Disparität

Bei einer Stereokamera wird die Tiefe mithilfe eines Algorithmus berechnet, der normalerweise auf der Host-Plattform ausgeführt wird. Die beiden Bilder müssen jedoch über ausreichend Details und Textur verfügen, damit die Kamera effektiv funktioniert. . Aus diesem Grund werden Stereokameras für Außenanwendungen mit großem Sichtfeld empfohlen.

Stereovisionskameras werden häufig bei der medizinischen Bildgebung, den AR- und VR-Anwendungen, der 3D-Konstruktion und -Kartierung usw. eingesetzt.

Um mehr über das Funktionsprinzip von Stereokameras zu erfahren, lesen Sie bitte: Was ist eine Stereovisionskamera?

Time-of-Flight-Kamera

Time of Flight ( ToF ) versteht man die Zeit, die das Licht benötigt, um eine bestimmte Distanz zurückzulegen. Time-of-Flight-Kameras arbeiten nach diesem Prinzip. Dabei wird die Distanz zu einem Objekt anhand der Zeit geschätzt, die das ausgesendete Licht benötigt, um nach der Reflexion an der Oberfläche des Objekts zum Sensor zurückzukehren.

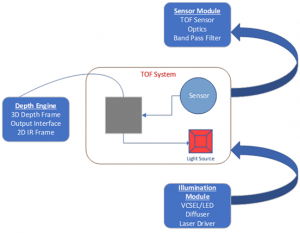

Eine Time-of-Flight-Kamera besteht aus drei Hauptkomponenten:

- ToF- Sensor und Sensormodul

- Lichtquelle

- Tiefensensor

Die Architektur einer Time-of-Flight-Kamera ist unten dargestellt:

Abbildung 2 – Architektur einer Time-of-Flight-Kamera

Der Sensor und das Sensormodul sind für die Erfassung der vom Zielobjekt reflektierten Lichtdaten verantwortlich. Der Sensor wandelt das erfasste Licht in Rohpixeldaten um. Die verwendete Lichtquelle ist entweder ein VCSEL oder eine LED, die typischerweise Licht im NIR-Bereich (Nahinfrarot) aussendet. Die Funktion des Tiefenprozessors besteht darin, die Rohpixeldaten des Sensors in Tiefeninformationen umzuwandeln. Darüber hinaus hilft er auch bei der Rauschfilterung und liefert 2D-IR-Bilder, die für andere Zwecke der Endanwendung verwendet werden können.

ToF -Kameras werden häufig in Anwendungen wie Smartphones und Unterhaltungselektronik, biometrischer Authentifizierung und Sicherheit, autonomen Fahrzeugen und Robotik usw. eingesetzt.

Basierend auf den Methoden zur Bestimmung der Entfernungen gibt es zwei Arten von ToF : Direkte Lichtlaufzeit ( DToF ) und indirekte Lichlaufzeit ( iToF ). Lassen Sie uns jeden dieser Typen und seine Unterschiede im Detail betrachten.

Direkte Lichtlaufzeit ( dToF )

der Direct- ToF -Methode wird die Szene mit Impulsen unsichtbaren Infrarot-Laserlichts abgetastet. Das von den Objekten in der Szene reflektierte Licht wird analysiert, um die Entfernung zu messen.

Die Entfernung von der dToF -Kamera zum Objekt kann gemessen werden, indem die Zeitspanne berechnet wird, die der Lichtimpuls vom Sender benötigt, um das Objekt in der Szene zu erreichen und dann wieder zurück. Zu diesem Zweck verwendet die dToF -Kamera ein Sensorpixel namens Single Photon Avalanche Diode (SPAD). Die SPAD kann den plötzlichen Photonenanstieg erkennen, wenn der Lichtimpuls vom Objekt zurückreflektiert wird. Auf diese Weise verfolgt sie die Zeitspannendes Photonenanstiegs und misst die Zeit.

dToF -Kameras haben normalerweise eine niedrige Auflösung. Die Vorteile von dToF -Sensoren sind ihre Kompaktheit und ihr geringer Preis. dToF -Kameras sind ideal für Anwendungen, die keine hohe Auflösung und Echtzeitleistung erfordern.

Schauen wir uns die Details von LiDAR an, einer dToF -Technologie, die Infrarot-Laserstrahlen zur Entfernungsmessung nutzt.

LiDAR

LiDAR-Kameras (Light Detection and Ranging) projizieren mit einem Laseremitter ein Rasterlichtmuster auf die aufzunehmende Szene und scannen diese hin und her.

Der Kamerasensor zeichnet die Zeitspanne auf, die der Lichtimpuls benötigt, um das Objekt zu erreichen und zu sich selbst zurückzureflektieren. Dadurch kann das LiDAR-System anhand der Lichtgeschwindigkeit die Entfernung zum Objekt messen, das das Licht reflektiert hat.

Mit LiDAR-Sensoren lässt sich eine 3D-Karte des erfassten Bereichs erstellen. Diese Sensoren können die Szene scannen, um basierend auf der gemessenen Entfernung und der Richtung des eingestrahlten Lichts ein einzelnes Datenbild zu erzeugen. Diese Aufnahmebilder enthalten Hunderte oder sogar Tausende von Datenpunkten. Sobald das LiDAR-System den Scan abgeschlossen hat, generiert es basierend auf der Position der erfassten Punkte eine Punktwolke. Ein weiterer Vorteil von LiDAR-Systemen besteht darin, dass sie im kontinuierlichen Streaming-Modus verwendet werden können.

Verschiedene LiDAR-Systeme werden für unterschiedliche Anwendungen eingesetzt. Da LiDAR-Systeme einen kollimierten und fokussierten Laserstrahl verwenden, um den Bereich eines Ziels abzutasten, erweisen sie sich auch bei großen Entfernungen als effektiv. Es sind auch LiDAR-Sensoren mit geringem Stromverbrauch erhältlich, die zur Tiefenmessung bei kurzen Entfernungen verwendet werden können. Sie können auch bei unterschiedlichen Lichtverhältnissen verwendet werden, reagieren jedoch empfindlich auf Umgebungslicht bei Außenbeleuchtung.

LiDAR-Sensoren verwenden normalerweise Infrarotlaser mit einer von zwei Wellenlängen: 905 Nanometer und 1550 Nanometer . Die Laser mit kürzerer Wellenlänge werden weniger wahrscheinlich von Wasser in der Atmosphäre absorbiert und eignen sich besser für Langstreckenvermessungen. Im Vergleich dazu können die Infrarotlaser mit längerer Wellenlänge in augensicheren Anwendungen wie Robotern eingesetzt werden, die in der Nähe von Menschen agieren.

Indirekte Lichtlaufzeit ( iToF )

Indirekte Time-of-Flight-Kameras ( iToF ) beleuchten die gesamte Szene mithilfe mehrerer Emitter mit diffusem Infrarot-Laserlicht. Diese Beleuchtung erfolgt durch eine Reihe modulierter Laserimpulse. Das Licht wird kontinuierlich moduliert, indem die Laseremitter mit hoher Frequenz gepulst werden.

Bei iToF wird das Zeitintervall zwischen jedem Lichtimpuls nicht direkt gemessen, wie bei dToF . Die iToF- Kamera zeichnet die Phasenverschiebung der Wellenform auf und vergleicht sie, die im Sensorpixel aufgezeichnet wird. Zwischen jedem Pixel wird verglichen, wie stark die Wellenform phasenverschoben ist, wodurch die Entfernung zum Punkt in der Szene berechnet werden kann.

Mit iToF- Kameras kann mit einer einzigen Aufnahme die Entfernung zu allen Punkten in der Szene bestimmt werden.

Wenn Sie mehr über die Funktionsweise einer Time-of-Flight-Kamera erfahren möchten:

Lesen Sie: Was ist ein ToF- Sensor? Was sind die Hauptkomponenten einer ToF- Kamera?

Lesen Sie: Wie sich Time-of-Flight ( ToF ) mit anderen 3D-Tiefenmapping-Technologien vergleichen lässt.

Strukturierte Lichtkamera

Eine Tiefensensor-kamera mit strukturiertem Licht verwendet eine Laser-/LED-Lichtquelle, um Lichtmuster (meistens Streifenmuster) auf das Zielobjekt zu projizieren. Anhand der erhaltenen Verzerrungen kann die Entfernung zum Objekt berechnet werden. Ein 3D-Scanner mit strukturiertem Licht wird häufig verwendet, um das 3D-Modell eines Objekts zu rekonstruieren.

Strukturierte Lichtkameras eignen sich für Anwendungen wie 3D-Scannen und -Modellierung , Qualitätskontrolle und -inspektion, biometrische Authentifizierung, Erhaltung des kulturellen Erbes, Einzelhandel und E-Commerce usw.

Vergleich zwischen den Tiefensensortechnologien

Alle oben besprochenen 3D-Tiefenmapping-Kameras haben ihre eigenen Vor- und Nachteile. Die Wahl der verwendeten Kamera hängt ganz von den Besonderheiten Ihrer Endanwendung ab. Es wird immer empfohlen, dass Sie sich von einem Bildgebungsexperten wie e-con Systems helfen lassen, der Sie durch den Kamerabewertungs- und Integrationsprozess führt.

Die Technologien können anhand von zehn verschiedenen Parametern analysiert werden . Einen detaillierten Vergleich finden Sie in der folgenden Tabelle:

| STEREOSICHT | STRUKTURIERTES LICHT | dToF | iToF | |

| Prinzip | Vergleicht Unterschiede zwischen Stereobildern zweier 2D-Sensoren | Erkennt Verzerrungen von beleuchteten Mustern durch 3D-Oberfläche | Gemessen wird die Zeit, die das reflektierte Licht von einem Objekt zum Sensor benötigt. | Die Phasenverschiebung modulierter Lichtimpulse wird gemessen |

| Softwarekomplexität | Hoch | Mittel | Niedrig | Mittel |

| Materialkosten | Niedrig | Hoch | Niedrig | Mittel |

| Tiefe(“z”) Genauigkeit | cm | um~cm | mm~cm | mm~cm |

| Tiefenbereich | Beschränkt | Skalierbar | Skalierbar | Skalierbar |

| Schwaches Licht | Schwach | Gut | Gut | Gut |

| Im Freien | Gut | Schwach | Gerecht | Gerecht |

| Reaktionszeit | Mittel | Langsam | Schnell | Sehr schnell |

| Kompaktheit | Niedrig | Hoch | Hoch | Mittel |

| Energieverbrauch | Niedrig | Mittel | Mittel | Scalable-Medium |

Beliebte Embedded Vision-Anwendungen, die Tiefensensor-kameras verwenden

Wie bereits erwähnt, ist Tiefensensorik für jedes Gerät erforderlich, das autonom navigieren muss. Im Folgenden sind jedoch einige der beliebtesten Embedded-Vision-Anwendungen aufgeführt, die 3D-Tiefen-kameras für ihr reibungsloses Funktionieren benötigen:

- Autonome mobile Roboter (AMR)

- Autonome Traktoren

- Personenzähl- und Gesichtserkennungssysteme für Anti-Spoofing

- Fernüberwachung von Patienten

Autonome mobile Roboter

Autonome mobile Roboter (AMR) haben dazu beigetragen, verschiedene Aufgaben in Industrie, Einzelhandel, Landwirtschaft und Medizin zu automatisieren. Im Folgenden finden Sie einige Beispiele für AMRs, die in Lagern, Einzelhandelsgeschäften, Krankenhäusern, Bürogebäuden, landwirtschaftlichen Feldern usw. eingesetzt werden.

- Ware-zur-Person-Roboter

- Pick-and-Place-Roboter

- Telepräsenzroboter

- Ernteroboter

- Automatische Unkrautvernichter

- Patrouillenroboter

- Reinigungsroboter

Unabhängig vom Typ muss jeder Roboter, der sich autonom und ohne menschliche Aufsicht bewegen muss, mit einer 3D-Tiefenkamera ausgestattet sein. Einige Roboter, die eine Tiefenkamera verwenden, nutzen möglicherweise eine Kombination aus automatisierter und menschlicher Navigation. Selbst in diesen Fällen helfen Tiefenkameras dabei, Hindernisse zu erkennen und Unfälle zu vermeiden. Ein Beispiel für diesen Robotertyp ist ein Lieferroboter.

Um besser zu verstehen, wie Tiefenkameras in AMRs funktionieren, lesen Sie bitte den Artikel „ Wie nutzt ein autonomer mobiler Roboter die Time-of-Flight-Technologie?“.

Erfahren Sie, wie e-con Systems einem führenden Hersteller autonomer mobiler Roboter dabei geholfen hat, die Lagerautomatisierung durch die Integration von Kameras zu verbessern, um eine genaue Objekterkennung und fehlerfreies Lesen von Barcodes zu ermöglichen.

Autonome Traktoren

Autonome Traktoren werden eingesetzt, um wichtige landwirtschaftliche Prozesse wie Unkraut- und Insektenerkennung, Ernteüberwachung usw. zu automatisieren. Sie funktionieren ähnlich wie AMRs, wenn es um die Tiefenerkennung geht. Tiefenkameras helfen ihnen, die Entfernung zu Hindernissen und nahe gelegenen Objekten zu messen, um sich von einem Punkt zum anderen zu bewegen. Diese Fähigkeit, sich autonom fortzubewegen, ist angesichts des Arbeitskräftemangels in der Landwirtschaft ein Wendepunkt.

Personenzähl- und Gesichtserkennungssysteme

Personenzähl- und Gesichtserkennungssysteme dienen der Personenzählung und Betrugserkennung beim Identitätsmanagement und bei der Zugangskontrolle. 3D-Tiefenkameras wie Stereokameras und Time-of-Flight-Kameras werden hier benötigt, um die genaue Position bzw. den Standort einer Person während der Zählung oder Gesichtserkennung zu lokalisieren.

Fernüberwachung von Patienten

Moderne Fernüberwachungssysteme für Patienten nutzen künstliche Intelligenz und Kameratechnologie, um wichtige Ereignisse wie Stürze von Patienten zu erkennen und eine völlig menschenfreie Patientenüberwachung rund um die Uhr zu ermöglichen. Um Stürze zu erkennen, muss jedoch das Video des Patienten aufgezeichnet und zur Analyse freigegeben und gespeichert werden. Dies ruft Bedenken hinsichtlich der Privatsphäre hervor. Hier kann eine 3D-Tiefenkamera einen Unterschied machen.

Mithilfe dieser hochmodernen Kamerasysteme können Patientenbewegungen allein anhand von Tiefendaten verfolgt werden. Dies gewährleistet die Privatsphäre und gibt dem Patienten Sicherheit, da von der Kamera zur Patientenfernüberwachung keine visuell identifizierbaren Bilder oder Videos verarbeitet werden .

Wenn Sie weiter darüber lesen möchten, wie 3D-Tiefenkameras (insbesondere Time-of-Flight-Kameras) Patientenüberwachungssystemen dabei helfen, die Privatsphäre zu verbessern, lesen Sie bitte: Wie macht eine Time-of-Flight-Kamera die Fernüberwachung von Patienten sicherer und privater?

Das war’s zum Thema Tiefensensorkameras. Falls Sie weitere Fragen zu diesem Thema haben, hinterlassen Sie gerne einen Kommentar.

e-con Systems bietet leistungsstarke Tiefensensorkameras

e-con Systems ist ein Branchenpionier mit über 20 Jahren Erfahrung bei der Entwicklung und Herstellung von OEM-Kameras. Wir haben tiefenempfindliche ToF -Kameras, die NVIDIA Jetson-Verarbeitungsplattformen unterstützen und mit USB-, GMSL- und MIPI CSI 2-Schnittstellen kompatibel sind. ToF- Kameras bei e-cons verfügen außerdem über erweiterte Funktionen wie Global Shutter-Funktionen, Unterstützung mehrerer Kameras, IR-Bildgebung und komplexe Bildverarbeitungsfunktionen.

Wenn Sie beim Integrieren von 3D-Tiefenkameras in Ihr autonomes Fahrzeug Hilfe brauchen , schreiben Sie uns bitte an camerasolutions@e-consystems.com .

Beachten Sie, dass wir auch Anpassungsdienste anbieten, um sicherzustellen, dass die Kamera alle Anforderungen für Ihre angegebene Anwendung erfüllt.

Sie können auch den Kameraselektor besuchen , um sich unser komplettes Kameraportfolio anzusehen.

Prabu ist Chief Technology Officer und Head of Camera Products bei e-con Systems und verfügt über eine reiche Erfahrung von mehr als 15 Jahren im Bereich der eingebetteten Bildverarbeitung. Er bringt umfassende Kenntnisse in den Bereichen USB-Kameras, eingebettete Bildverarbeitungskameras, Bildverarbeitungsalgorithmen und FPGAs mit. Er hat über 50 Kameralösungen für verschiedene Bereiche wie Medizin, Industrie, Landwirtschaft, Einzelhandel, Biometrie und mehr entwickelt. Er verfügt außerdem über Fachwissen in der Gerätetreiberentwicklung und BSP-Entwicklung. Derzeit liegt der Schwerpunkt von Prabu auf der Entwicklung intelligenter Kameralösungen, die KI-basierte Anwendungen des neuen Zeitalters ermöglichen.